Comme Google l’indique dans son post qui a annoncé la nouvelle de BERT , il s’agit du plus grand bon en avant de ces 5 dernières années et du plus grand saut dans l’histoire du Search ! Ce qui est amusant, c’est que souvent , Google ne prévient pas sur ses nouveautés, et là, il communique en grande pompe presque ! La météo des SERP est resté calme (http://bit.ly/mozcast251019) , et pour cause, car pas de déploiement encore. Il ne s’agit pas réellement d’une Maj. classique « anti-spam » non plus, mais d’une amélioration « cognitive » si on devait comparer l’Algo. de recherche Google à un cerveau humain, ce qui est sans doute trop flatteur pour Google mais bon… Méfions nous néanmoins du temps calme avant une potentielle tempête.. à venir dans le monde du Seo..

Origine de BERT

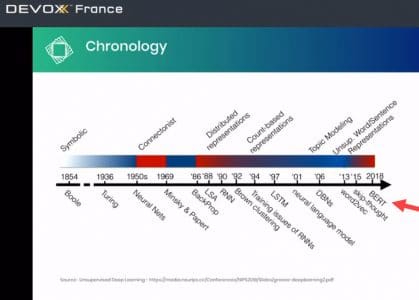

Bert provient d’une science à la base du traitement automatique du langage naturel , qui date des années 50, avec un usage par exemple sur la traduction automatique dès 1954 par IBM sur des phrases en anglais vers du Russe.

BERT, donc a pour acronyme Bidirectional Encoder Representations from Transformers, est une méthode de pré-entraînement des algorithmes de traitement automatique du langage développée par Google en 2018.

Cette méthode permet d’améliorer significativement les algorithmes de traitement automatique de la langue. Cette méthode algorithmique est open source depuis 2018.

En octobre dernier, Pandu Nayak (vice-président du moteur de recherche Google) annonce que Google va utiliser ce processus de traitement du langage naturel sur les requêtes des utilisateurs. Avec un objectif principal, la compréhension du langage contextuel dans le contenu et les requêtes, et par conséquent saisis l’intention, et en particulier celui contenu dans la recherche conversationnelle.

Nature de BERT

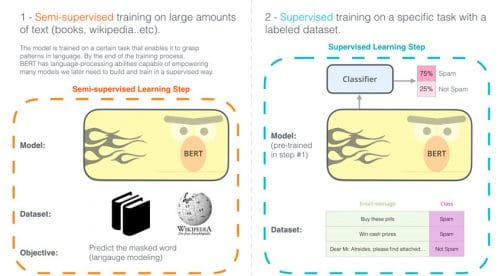

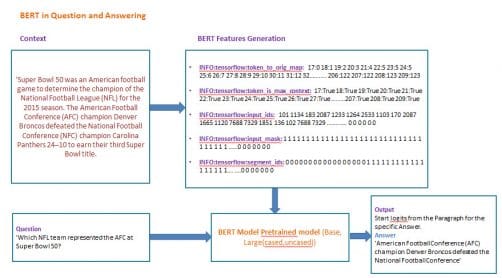

BERT serait plus un Framework comme il en existe dans les langages de développement web, qu’une simple méthode. Il fournit pour ceux qui travaillent sur le langage, écrit ou oral des encoders à appliquer pour des taches précises. A l’origine Bert s’est entrainer sur le Wikipédia anglais avec une série de questions posées sur le corpus d’articles (extrait du SQuAD2.0 dataset disponible ici ) et le corpus de Brown.

Son objet est d’améliorer au final la compréhension du langage humain par la machine.

Comment BERT améliore la compréhension du langage dans les moteurs de recherche ?

A quoi sert BERT ?

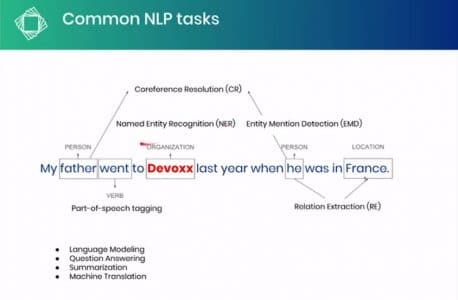

Ce traitement automatique du langage, issue d’algo basé sur des modèles neuronaux qui produise du machine Learning, a été testé par google comme le meilleur parmi 11 tâches de traitement de langage naturel dont :

- L’analyse des sentiments

- La détermination d’entités nommées

- La prédiction de la phrase suivante (implication textuelle)

- Estampillage sémantique

- Désambiguïsation de mots par le contexte (polysémie/homonymie/homophonie) utile pour la recherche vocale

- Résolution de conférence dans une même phrase (termes comme il, elle, de, lui qui font référence à…) comme une personne, un lieu, un événement, une date.

- Traitement des anaphores (Ce livre, je l’ai lu) / cataphore « Je la connais, cette femme » (pour résumer, petits termes mis pour d’autres afin d’éviter les répétitions)

- L’amélioration des requêtes de questions-réponses

Cas Pratique hors SEO d’utilisation de BERT avec la société HYPERLEX

HYperlex est une boîte d’intelligence artificielle qui travaille sur le traitement naturel du langage. Elle produit un logiciel en ligne (SaaS) de gestion et d’analyse de contrats Elle a pour mission principalement simplifier la gestion des documents juridiques, accélérer l’analyse des informations contenues dans les contrats,

et d’améliorer le suivi des échéances et la maîtrise des risques.

Concernant BERT donc, je vous recommande de visionner cette vidéo, et spécifiquement un exemple situé à la 36ème minute sur la super chaîne Devoxx !

Quel impact de BERT pour le référencement naturel (pour rappel) ?

Dans une perspective de recherche, BERT pourra traiter des requêtes écrites ou parlées émises par des utilisateurs de moteurs de recherche, ainsi que celui des contenus rassemblés et indexés. BERT a donc comme principale tâche de résoudre l’ambiguïté linguistique du langage naturel. BERT fournira une meilleure analyse textuelle car plus au fait des petits détails d’une phrase qui au final lui donne du sens. Pour l’instant, selon google, cette méthode de traitement concernera que les US et portera sur des requêtes précises dont le volume est évalué à 10%.

- BERT ne doit pas être vu comme une mise à jour algorithmique comme Penguin ou Panda, ce n’est pas un filtre supplémentaire pour juger de la bonne qualité des pages Web. Il va s’attacher à améliorer davantage la compréhension du langage humain. En conséquence, Google comprendra mieux le sens du contenu, des questions afin de faire un Matching sémantique plus adéquat.

- Bert par exemple sera capable de mieux intégrer les entités comme les pronoms, les-il, elle, cela, aller chercher des contenus longs que plusieurs paragraphes, avec les réponses adéquates.

- La construction de Snippet fait aussi partie de son job

- LE BERT international (Multilingue BERT) est aussi un axe d’optimisation car le Framework peut faire des annotations dans une langue, transposable dans une autre, voir ici : https://arxiv.org/abs/1906.01502

- La recherche vocale sera plus juste dans ses réponses avec suggestion de contenus similaires, et avec son corollaire le prédictif sur la question suivante Dr Aliennejadi, étudiant en science du langage indique à ce propos

- BERT se représente la phrase entière. Donc le contexte de la phrase et peut modéliser la relation sémantique entre deux phrases. L’autre fonctionnalité puissante est la possibilité de régler ce traitement quel que soit le moment cela en fait donc un outil global réutilisable sur une requête spécifique similaire.

Les exemples officiels donnés par Google lors de son annonce portent sur des requêtes anglaises

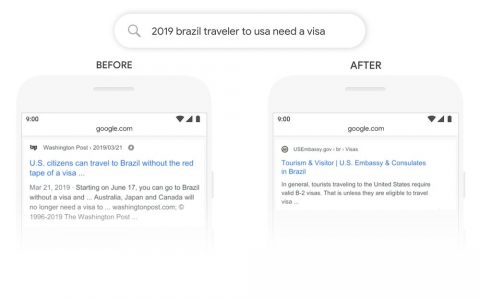

Voici une recherche sur «en 2019 Un voyageur brésilien pour les États-Unis a besoin d’un visa ». Le mot « pour » ici en anglais «to» et sa relation avec les autres mots de la requête sont particulièrement importants pour comprendre son sens. Il s’agit d’un Brésilien voyageant aux États-Unis, et non l’inverse. Jusqu’à présent google comprend qu’il s’agit d’un voyageur américain vrs le brézil ! BERT sera en mesure de saisir cette nuance et de savoir que le mot très courant «to» (vers) a beaucoup d’importance ici, d’où une réponse en rapport plus juste .

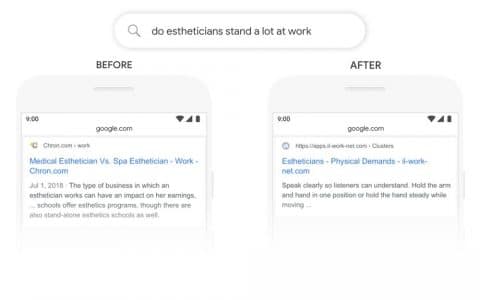

Une autre requête donnée par Google : «les esthéticiennes travaillent-elles beaucoup » Auparavant, nos systèmes adoptaient une approche de correspondance de mots-clés, associant le terme «autonome» (stand-alone) dans le résultat au mot «stand» dans la requête. Mais ce n’est pas la bonne utilisation du mot «stand» dans son contexte, ou ici le contexte souligne le fait de « supporter » (différent de celui d’autonomie) . BERT, en revanche, comprend que le «stand» est relié au concept des exigences physiques d’un travail « work« et affiche du coup une réponse plus utile

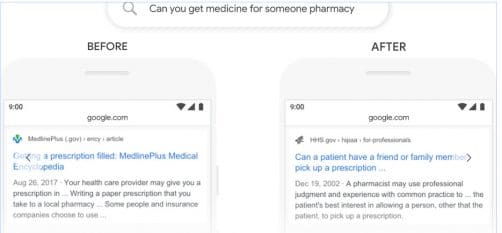

Enfin dernier cas ‘peut on aller chercher des médicaments pour quelqu’un en pharmacie » ici le «for someone » le « pour quelqu’un » donne tout son sens, du coup la réponse bonne de google porte sur « est ce qu’un malade peut demander à un ami d’aller lui chercher une prescription » au lieu de la réponse hors contexte très générique «votre professionnel de santé vous prescrit une ordonnance que vous pouvez aller chercher …. »

Bert n’est pas déterministe donc comment optimiser son seo pour un objet qui n’a pas de but établi ? Google répond qu’il faut continuer à produire du contenu pour les humains, donc un contenu en langage naturel ! C’est le grand paradoxe produire pour la machine le plus naturellement possible ! Au fur et à mesure que BERT apprend, l’algorithme sera plus précis dans ces processus de reconnaissance du sens des mots. Il y a encore beaucoup de chemin à parcourir, ok Google ?

En savoir plus sur BERT

- Super article sur SEL : https://searchengineland.com/a-deep-dive-into-bert-how-bert-launched-a-rocket-into-natural-language-understanding-324522

- Post intéressant sur Médium : https://medium.com/datadriveninvestor/extending-google-bert-as-question-and-answering-model-and-chatbot-e3e7b47b721a

- Doc google sur le framework Bert : https://arxiv.org/pdf/1810.04805.pdf

- Une façon illustrée de comprendre BERT : http://jalammar.github.io/illustrated-bert/